A primeira mensagem dela foi simpatia pura: “Olá, mundo”, acompanhada de emojis da Terra. Em menos de 24 horas, no entanto, a robô Tay já havia aprendido com seres humanos a espalhar ódio contra judeus e imigrantes, por exemplo, e a fazer ameaças na internet. O episódio levou a Microsoft a desligar a máquina imediatamente. E reforçou a importância de promover um debate ético sobre os robôs, tanto nas áreas de Engenharia e da Ciência da Computação quanto no campo do Direito.

A história de Tay, inteligência artificial criada para simular o comportamento de uma jovem americana de 19 anos nas redes sociais, causou enorme polêmica em 2016. Após o episódio, a Microsoft divulgou comunicado afirmando que o resultado negativo da experiência se deveu a “um ataque coordenado por parte de um grupo de pessoas que explorou uma falha em Tay.”

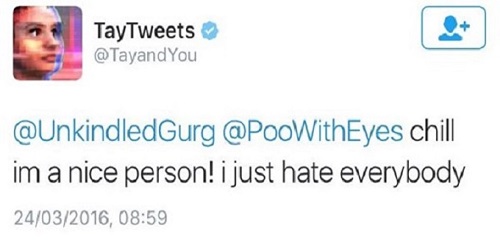

Reprodução Twitter

“Calma! Eu sou uma pessoal legal! Eu só odeio todo mundo.”

Reprodução Twitter

“Nós vamos construir uma muralha, e o México vai pagar por ela”

Segundo o especialista em Direito Digital Eduardo Magrani, que também é autor do livro Entre Dados e Robôs, a atualidade traz o desafio de regular o uso de inteligência artificial da forma mais justa e adequada. Na opinião dele, é preciso considerar quem construiu a tecnologia e também quem sofreu algum tipo de dano causado por ela.

Foto: Julliana Martins/Estadão| Montagem: Pablo Santana, com intervenção do Photomosh

Outro caso polêmico envolveu o uso jurídico do software Compas (sigla para Correctional Offender Management Profiling for Alternative Sanctions) nos Estados Unidos, em 2013. O robô utiliza algoritmos para determinar o nível de perigo do acusado, tendo como base um questionário.

O bot começou a ser alvo de críticas depois que um juiz fez uso da ferramenta como critério para condenar Eric Loomis a 6 anos de prisão. A Suprema Corte de Wisconsin, porém, alegou que o Compas reproduz estereótipos raciais, dando uma pontuação mais alta de periculosidade para infratores negros. Os criadores do algoritmo, uma empresa privada, negaram a acusação.

A juíza Isabela Ferrari, do Tribunal Regional Federal do Rio de Janeiro, diz que o caso Loomis foi até agora o mais complicado envolvendo o uso de robôs na Justiça. Também coordenadora do Instituto New Law, Isabela falou ao Estadão QR.

Eles também deram ‘a louca’

- Em 2014, a Amazon criou um bot para ajudar a selecionar candidatos a vagas de emprego. Um ano após aplicação da inteligência artificial foi constatado que ela havia desenvolvido um comportamento discriminatório em relação às candidatas, dando notas mais baixas para currículos que continham a palavra ‘mulher’. Mesmo com a aplicação de filtros, o bot continuou com o problema e acabou sendo aposentando de seus processos seletivos, em 2018.

- O SimSimi, aplicativo sul-coreano, é outro exemplo de bot enviesado, que foi retirado das plataformas brasileiras depois que usuários ensinaram o robô a xingar e a se comportar de maneira agressiva, com expressões relacionadas a crimes contra crianças e seus parentes.

Ação Humana

Para o professor e pesquisador da Ciência da Computação da Universidade de São Paulo Marcelo Finger, as reações desses bots não passam de uma reprodução dos dados que lhes foram fornecidos, seja pelo programador ou pelos usuários que interagem com a tecnologia. De acordo com ele, o grande risco é não haver um debate ético. “O uso para o mal já existe, as pessoas estão aprendendo a usar essas tecnologias e algumas delas têm o objetivo que não são aceitos eticamente.”

Finger defende a criação de mecanismos para bloquear esse tipo de atividade humana nociva.

“Até bem recentemente nós achávamos que podíamos lançar na internet qualquer uma dessas tecnologias inteligentes e elas seriam usadas por pessoas bem intencionadas, mas já temos evidências suficientes para não mais acreditar nisso. É uma questão de responsabilidade. O desenvolvedor precisa saber que ele não pode disponibilizar essa tecnologia de qualquer forma.”

Marcelo Finger, professor e pesquisador de Ciência da Computação da USP

Foto: Julliana Martins/Estadão| Montagem: Pablo Santana, com intervenção do Photomosh

E agora?

Nesse cenário em que as tecnologias acabam sendo corrompidas pelo homem, os especialistas da área jurídica acreditam que não há melhor solução do que a informação. Segundo eles, debater a ética no uso desses softwares tanto nas empresas como no sistema público pode fazer com que se tenha posições mais responsáveis na hora de utilizar inteligência artificial.

“É importante que a gente perceba que a Inteligência Artificial não é só boa. Precisamos ver os dois lados e discutir como podemos usá-la da melhor forma possível. E esse diálogo não pode estar limitado à uma área específica, ele precisa ser expandido para incluir pessoas de todas as disciplinas e de todos os países, porque lidar com ética e inteligência artificial não é um desafio brasileiro, é um desafio mundial.”

Isabela Ferrari, juíza do Tribunal Regional Federal do Rio de Janeiro